CLI

Agent TARS 提供了一个强大的命令行界面 (CLI),它支持以下命令:

agent-tars: 启动交互式 UIagent-tars serve: 启动无头服务器agent-tars run: 在静默模式下运行 Agent TARS 并将结果输出到标准输出agent-tars workspace: 管理 Agent TARS 全局工作区agent-tars request: 向模型提供商发送直接请求

所有命令

要查看所有可用的 CLI 命令,请在项目目录中运行以下命令:

输出如下所示:

Common Flags

Agent TARS CLI 提供了一些 Common Flags,可以与大多数命令一起使用:

| 标志 | 描述 |

|---|---|

-c, --config <path> | 配置文件或 URL 的路径,支持多个值 |

--port <port> | 服务器运行的端口(默认:8888) |

--open | 在服务器启动时在默认浏览器中打开 Web UI |

--logLevel <level> | 指定日志级别(debug、info、warn、error) |

--debug | 启用调试模式(显示工具调用和系统事件) |

--quiet | 将启动日志减少到最低限度 |

--model.provider <provider> | LLM 提供商名称 |

--model.id <model> | 模型标识符 |

--model.apiKey <apiKey> | 模型 API 密钥 |

--model.baseURL <baseURL> | 模型基础 URL |

--stream | 为 LLM 响应启用流模式 |

--thinking | 为兼容的模型启用推理模式 |

--toolCallEngine <engine> | 工具调用引擎类型(native、prompt_engineering、structured_outputs) |

--workspace <path> | 工作区目录的路径 |

--browser.control <mode> | 浏览器控制模式(mixed、browser-use-only、gui-agent-only) |

--planner.enabled | 为复杂任务启用规划功能 |

-h, --help | 显示命令帮助 |

agent-tars [start]

默认命令(或明确使用 agent-tars start)运行带有交互式 UI 的 Agent TARS。

你也可以通过简单地使用以下命令来运行交互式 UI:

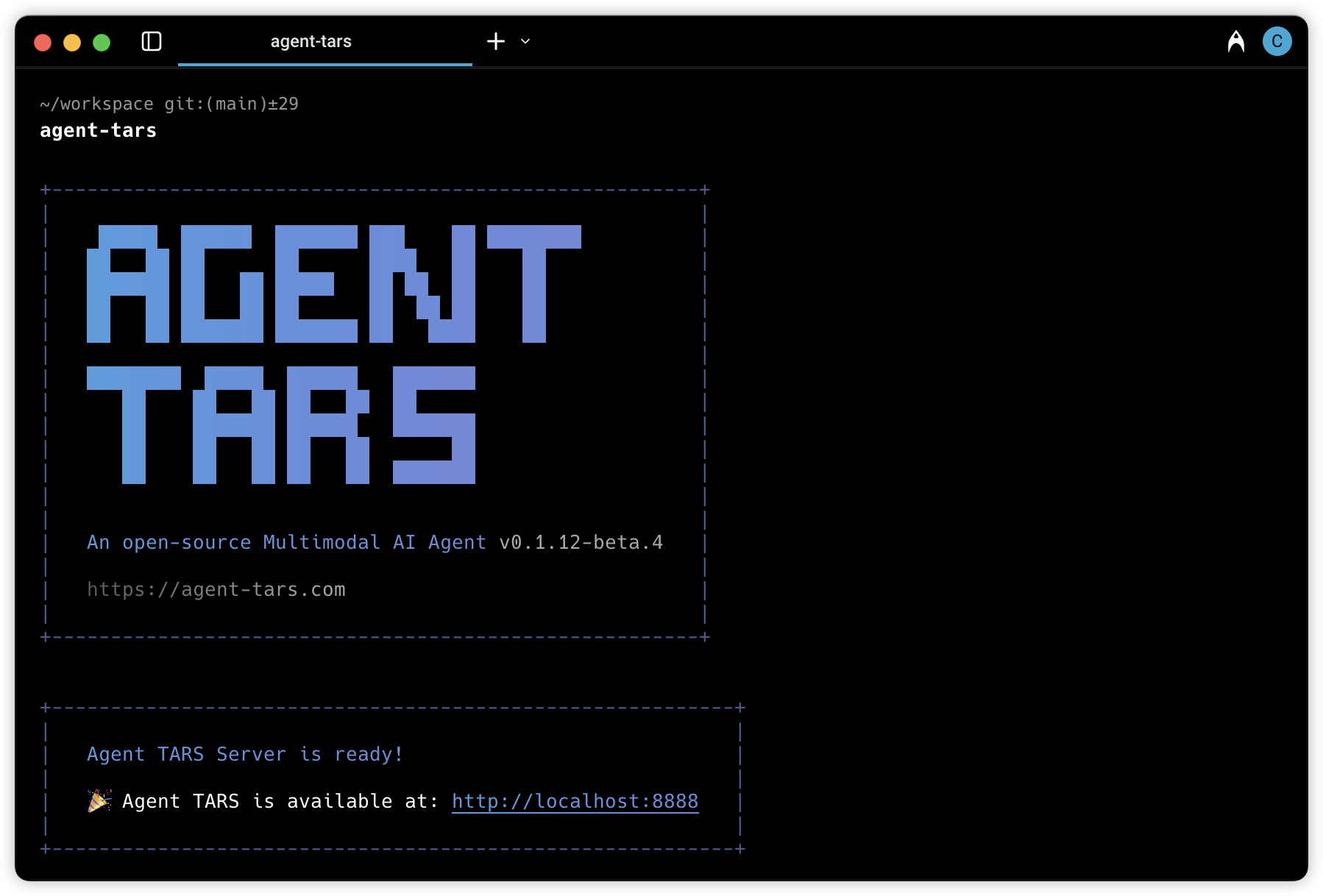

此命令将启动一个 Web 服务器,并显示一个欢迎消息,其中包含访问 UI 的 URL。

agent-tars serve

agent-tars serve 命令启动一个无头的 Agent TARS 服务器。

目前,此命令与交互式 UI 模式类似,但用于无头操作。

agent-tars request

agent-tars request 命令允许你向 LLM 提供商发送直接请求。

示例:

agent-tars run

agent-tars run 命令在静默模式下执行 Agent TARS,并将结果输出到标准输出。

示例:

agent-tars workspace

agent-tars workspace 命令帮助你管理 Agent TARS 工作区。

创建全局工作区

--init 选项创建一个带有配置文件的新 Agent TARS 工作区:

在初始化过程中,你将被提示选择:

- 配置格式(TypeScript、JSON 或 YAML)

- 默认模型提供商

- 是否初始化 git 仓库

打开全局工作区

如果有 VSCode,--open 选项会在其中打开你的工作区:

此命令将打开位于 ~/.agent-tars-workspace 的全局工作区。

配置文件

Agent TARS 会自动在当前目录中查找以下配置文件:

agent-tars.config.tsagent-tars.config.yml/agent-tars.config.yamlagent-tars.config.jsonagent-tars.config.js

你可以使用 --config 标志指定自定义配置文件:

可以指定多个配置文件,它们将按顺序合并:

还支持远程配置 URL:

环境变量

Agent TARS 支持环境变量用于存储 API 密钥等敏感信息。当你指定一个环境变量名(全大写)作为值时,Agent TARS 将使用该环境变量的值:

在此示例中,Agent TARS 将使用 OPENAI_API_KEY 和 OPENAI_BASE_URL 环境变量的值。